L’IA in Svizzera: condizioni quadro intelligenti con strumenti collaudati

- Introduction L’essenziale in breve | Posizione di economiesuisse

- Chapter 1 Introduzione

- Chapter 2 Cos’è l’intelligenza artificiale?

- Chapter 3 Aree di dibattito a livello di regolamentazione

- Chapter 4 Sviluppi internazionali

- Chapter 5 Discussione in Svizzera

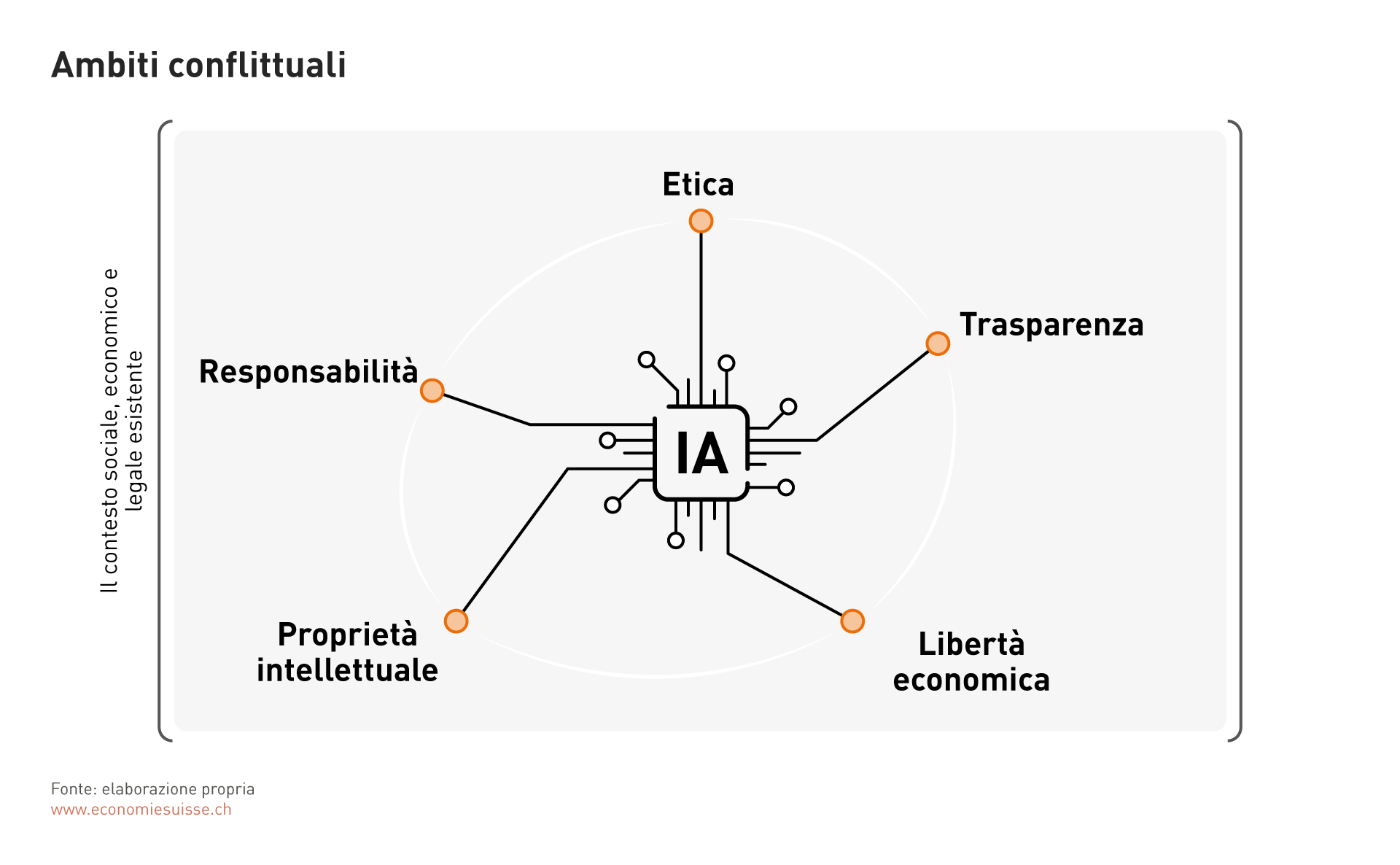

Aree di dibattito a livello di regolamentazione

Lo sviluppo dell'intelligenza artificiale solleva una serie di questioni che non sono solo di natura tecnica, ma toccano anche dimensioni etiche, economiche e legali. In questo dossierpolitica, vorremmo affrontare queste importanti questioni legate all'intelligenza artificiale e mostrare in che misura sono già coperte dal quadro sociale, economico e legale esistente in Svizzera. Il quadro giuridico dovrebbe essere adattato, anche caso per caso, solo laddove le normative esistenti non possono essere interpretate e applicate correttamente agli eventi che coinvolgono l'IA.

Etica

Le questioni etiche sono importanti sia per lo sviluppo che per l'uso dell'IA. Da un punto di vista strettamente giuridico, i principi puramente etici svolgono un ruolo solo nella misura in cui sono espressamente e concretamente formulati in norme giuridiche. Ma l'abbondante giurisprudenza relativa al principio generale di buona fede (art. 2 CC) e i principi di buona governance aziendale contengono numerose norme incorporate sulla base di un desiderio di correttezza o di etica. Nel caso dell'IA, è particolarmente importante tenere presente che i processi pilotati da essa devono soddisfare i requisiti etici della nostra società, ossia i nostri valori e standard fondamentali.

Incorporare i principi etici nel processo di sviluppo dei sistemi di IA aiuta a garantire che le applicazioni siano degne della fiducia degli utenti e quindi del pubblico in generale. A questo proposito, le aziende dovrebbero essere consapevoli della responsabilità che accompagna la creazione di tecnologie di IA e impegnarsi a rispettare le linee guida etiche.

A tale proposito sono particolarmente rilevanti gli aspetti seguenti:

Disparità di trattamento: I sistemi di IA possono rafforzare e promuovere i pregiudizi se non vengono allenati sulla base di serie di dati rappresentative. Ciò può portare a una disparità di trattamento ingiustificata, che deve essere presa in considerazione quando si sviluppano e si utilizzano i sistemi di IA. È necessario garantire che vengano utilizzati in modo equo e che la differenziazione, ad esempio tra diversi gruppi di clienti, avvenga solo nella misura in cui lo suggeriscono argomenti materialmente convincenti.

Esistono già strumenti giuridici per combattere la disparità di trattamento senza motivo materiale. In Svizzera, ad esempio, la Costituzione vieta la discriminazione, soprattutto da parte dello Stato, ma si applica anche ai privati che svolgono funzioni statali.

Oggi la dottrina riconosce ampiamente che una disparità di trattamento senza motivi sostanziali nella conclusione di un contratto possa costituire una violazione della personalità. Non si tratta di una protezione assoluta contro la disparità di trattamento, ma di un «divieto indiretto di discriminazione nel diritto privato», nel senso che una disparità di trattamento basata su caratteristiche di una persona protetta dai suoi diritti della personalità può costituire una violazione della personalità.

Il diritto della personalità e il diritto penale si applicano anche a situazioni che comportano applicazioni ingiuste, scorrette o fuorvianti dell'IA: è il caso, ad esempio, dei "deep fake", dove la rappresentazione ingiuriosa o falsificata di una persona può quindi costituire un attacco alla sua personalità. Laddove vi sia l'intenzione di ingannare, sono presenti gli elementi costitutivi di un reato penale, anch'essi formulati in modo tecnologicamente neutrale.

Altri testi impongono chiaramente la parità di trattamento tra gli individui. È il caso della legge federale sulla parità tra donne e uomini e di quella sull’eliminazione delle disparità che colpiscono le persone disabili.

Un’intelligenza artificiale ben utilizzata può persino prevenire la disparità di trattamento. I sistemi di intelligenza artificiale possono quindi essere più neutrali degli esseri umani o, sulla base delle decisioni, identificare modelli che indicano una disparità di trattamento.

Privacy e protezione dei dati: quando si utilizzano sistemi di intelligenza artificiale, è necessario prestare attenzione per garantire che le norme applicabili sulla protezione dei dati siano rispettate sia in relazione ai dati forniti che ai risultati generati.

In Svizzera è soprattutto la nuova legge sulla protezione dei dati (LPD) ad essere rilevante. Ciò vale per il trattamento dei dati personali da parte di privati e organi federali. All’inizio di novembre 2023 il responsabile federale della protezione dei dati e della trasparenza (IFPDT) ha confermato che la legge sulla protezione dei dati attualmente in vigore è direttamente applicabile all’IA. Particolarmente rilevanti a questo proposito sono le seguenti disposizioni:

- Minimizzazione dei dati (art. 6, cpv. 2 LPD),

- dovere di informare / trasparenza (art. 19 LPD),

- profilazione (art. 5, let. f-g LPD), m

- decisioni individuali automatizzate (art. 21, cpv. 1-3 LPD)

- diritto d’accesso (art. 25 LPD).

Un’analisi dei diversi ambiti interessati dall’uso dell’IA mostra che l’attuale quadro giuridico offre quasi sempre un sostegno adeguato. Questo è il caso oggi e spetterà al legislatore agire in tempo utile per risolvere i casi – nel caso in cui l’evoluzione della tecnologia crei lacune nella legge.

L’IA e lo Stato

Come abbiamo spiegato, il divieto di discriminazione nei rapporti tra Stato e cittadini va molto lontano e costituisce una condizione importante per il rispetto dei diritti costituzionali dei cittadini in una democrazia liberale come la Svizzera.

Nelle sue linee direttive sull’intelligenza artificiale per l’amministrazione federale, la Confederazione affronta la questione del rischio di discriminazione derivante dai set di dati quando le decisioni si basano sull’intelligenza artificiale. Mette al centro l’essere umano, la sua dignità e il suo benessere. L’utilizzo dell’AI deve «sostenere le pari opportunità per le persone, ma anche incoraggiare e facilitare l’accesso alla formazione, ai beni, ai servizi e alle tecnologie». I diritti fondamentali devono essere sempre rispettati. Laddove vi sia la probabilità che i diritti fondamentali vengano violati, in particolare nel contesto dei sistemi di autoapprendimento, dovrebbe essere effettuata una valutazione d’impatto globale. Questo processo dovrebbe essere accompagnato da un monitoraggio continuo per mettere in atto tutele e controlli adeguati. L’obiettivo primario è tutelare le persone interessate da ogni discriminazione e stigmatizzazione. Allo stesso tempo, il rispetto della privacy dovrebbe essere garantito attraverso una rigorosa applicazione delle disposizioni sulla protezione dei dati. Questi sviluppi si svolgono in modo analogo a quelli all’interno del Consiglio d’Europa. (cf. X.X.). L’obiettivo è anche garantire che le autorità pubbliche non utilizzino gli strumenti di intelligenza artificiale in un modo che non sarebbe appropriato in una società liberale come quella svizzera.

Trasparenza

Come regola generale, le decisioni sono accettate quando vengono prese in modo trasparente e quindi comprensibile. Lo stesso vale per le decisioni prese utilizzando l’intelligenza artificiale. Gli utenti devono essere in grado di sapere quando una decisione è stata presa da un’intelligenza artificiale. Dovrebbero anche capire come i sistemi di intelligenza artificiale arrivano alle loro conclusioni. Ciò non solo promuove la fiducia, ma aiuta anche a identificare e correggere possibili errori o pregiudizi nei sistemi. In queste condizioni, è essenziale sviluppare metodi per spiegare le decisioni dell’IA. Ciò richiede processi trasparenti. Come base giuridica può quindi essere utilizzata la nuova legge svizzera sulla protezione dei dati: essa prevede ampie disposizioni in materia di trasparenza per quanto riguarda le decisioni automatizzate. Allo stesso tempo, dovrebbero essere evitate richieste eccessive. Le decisioni prese dagli esseri umani possono, infatti, anche mancare di trasparenza e basarsi su numerosi pregiudizi (non sempre consapevoli).

Anche per l’OCSE la trasparenza è importante per garantire la tracciabilità. Richiede agli attori dell’IA di dimostrare trasparenza al fine di «promuovere una comprensione generale dei sistemi di intelligenza artificiale» nonché la consapevolezza e la comprensione delle interazioni con i sistemi di intelligenza artificiale.

Libertà economica

La libertà economica e la libertà contrattuale sono due dei pilastri di un’economia dinamica caratterizzata dalla libera concorrenza. In Svizzera la libertà economica è un diritto fondamentale ai sensi dell’art. 26 Cost. La libertà contrattuale, sancita dal codice delle obbligazioni, significa che, nei limiti della legge, ognuno è libero di decidere con chi desidera entrare in un rapporto contrattuale. È importante sottolineare che i sistemi di intelligenza artificiale non limitano queste libertà, ma possono addirittura supportarle. L’intelligenza artificiale può essere utilizzata come strumento per prendere decisioni fondate e sviluppare modelli commerciali innovativi. Per quanto riguarda la regolamentazione dell’IA, dobbiamo garantire che la libertà economica, e in particolare la libertà contrattuale, rimanga garantita.

Un contratto deve in linea di principio rispettare i limiti posti dal codice delle obbligazioni, in particolare dagli artt. 19, par. 2 e dell'art. 20, par. 1. Allo stesso tempo, l’individualizzazione non è vietata, indipendentemente dal fatto che venga utilizzata l’intelligenza artificiale. L'individualizzazione nel senso della libertà contrattuale è in linea di principio possibile e tale deve rimanere. Poter personalizzare l'offerta è infatti essenziale per la libera concorrenza.

Proprietà intellettuale

Le questioni relative alla proprietà intellettuale in relazione all'IA sono numerose: i sistemi di IA sono spesso sviluppati ed esercitati sulla base di grandi volumi di dati, algoritmi e lavori creati dall'uomo.

I problemi relativi ai diritti d’autore sorgono anche in relazione ai risultati generati dai sistemi di intelligenza artificiale. Quando i dati vengono elaborati con l'intelligenza artificiale, i dati protetti possono essere copiati digitalmente, violando così i diritti degli autori. I frammenti di un risultato generato da ChatGPT possono quindi essere protetti dal diritto d'autore, per cui un potenziale utente violerebbe inconsapevolmente tali diritti.

Ci sono ancora dubbi sulla paternità dei risultati prodotti da un'IA. Se un'IA è in grado di produrre beni immateriali a basso costo, potrebbe essere necessario adeguare il diritto di proprietà intellettuale. In particolare, quando i sistemi di IA generano autonomamente opere creative, si pone la questione della protezione e dell'"inventore" di tali opere. Se diventa difficile attribuire chiaramente atti creativi o inventivi agli esseri umani o ai sistemi di IA, i criteri tradizionali di "creazione intellettuale" e "attività inventiva", potrebbero essere messi in discussione. È possibile attribuire una prestazione intellettuale a un prodotto creato da un'IA? La giurisprudenza dovrà quindi sviluppare questo tema per definire i limiti del diritto di proprietà intellettuale in relazione all'IA.

Le possibilità offerte dall'IA sollevano anche questioni relative al diritto dei brevetti. Non c'è ancora una risposta alla domanda se un'IA possa essere anche un inventore, o a chi appartenga questo ruolo, o a quale livello di autonomia un umano che utilizza un'IA non sia più considerato un inventore. Per trovare una risposta, dobbiamo innanzitutto risalire all'idea originaria che sta alla base della legislazione in questione e trasporla alla situazione particolare di un'IA.

Ma non vi è alcuna necessità urgente di adattare il diritto della proprietà intellettuale per tenere conto dell'ascesa dell'IA, poiché la legge attuale sembra offrire una flessibilità sufficiente. Tra i tribunali, che continueranno a sviluppare i concetti giuridici pertinenti, e le discussioni nei circoli specializzati, emergerà un approccio appropriato e adeguato. A livello internazionale, esistono già alcune soluzioni provvisorie, sulla base delle quali i tribunali stanno chiarendo le questioni in sospeso. Ciò sarà possibile anche in Svizzera.

Responsabilità

L'uso di sistemi di intelligenza artificiale comporta rischi in termini di responsabilità. La prima questione che si pone è quella dell'"autonomia" e, in secondo luogo, quella di sapere quando un'IA ha effettivamente causato un danno.

Immaginiamo un robot tagliaerba che, invece di tagliare il prato del suo proprietario, taglia l'aiuola del vicino. Una volta che il danno è stato fatto, in primo luogo, il vicino chiede di essere rimborsato per i suoi fiori; in secondo luogo, il proprietario del robot viene convocato dal vicino per pagare; in terzo luogo, il produttore del robot viene citato in giudizio dal proprietario.

A questo proposito è necessario distinguere tra una decisione errata e un difetto del prodotto. La prima si verifica se «di fronte a una scelta tra più alternative, si sceglie il comportamento che porta al danno o all'aggravamento del danno«, mentre il difetto del prodotto «deriva da un difetto dei suoi componenti».

In Svizzera, la legge sulla responsabilità dei prodotti (LRDP) disciplina, tra l'altro, la responsabilità del produttore per i prodotti difettosi. Questa legge presenta alcune analogie con la direttiva europea 85/374/CEE, che deve essere rivista, in particolare alla luce del rapido ritmo dell'evoluzione tecnologica. In questo contesto, vengono affrontati diversi punti deboli del regime di responsabilità per danno da prodotto, come il campo di applicazione limitato ai prodotti nonostante la crescente importanza del software, la determinazione della difettosità dei prodotti che possono essere sviluppati o la possibilità di far valere i diritti a causa della suddivisione dell'onere della prova. Il legislatore svizzero farebbe bene a prendere in seria considerazione anche questi aspetti.

Attualmente, un sistema di intelligenza artificiale non può essere un soggetto responsabile perché non ha capacità giuridica. Non è ancora noto se un sistema di intelligenza artificiale rientri nella definizione di software della legge sulla responsabilità del prodotto. Nell'ambito della responsabilità, alcune questioni rimangono aperte e sarà interessante vedere come la giurisprudenza risponderà ad esse. La distinzione tra difetto del prodotto e decisione inappropriata, menzionata in precedenza, giocherà probabilmente un ruolo importante a questo proposito.