L’IA en Suisse: des conditions-cadre de qualité avec des instruments qui ont fait leurs preuves

- Introduction L’essentiel en bref | Position d’economiesuisse

- Chapter 1 Introduction

- Chapter 2 Qu’est-ce que l’intelligence artificielle?

- Chapter 3 Champs de tension réglementaires

- Chapter 4 Évolutions internationales

- Chapter 5 Discussion en Suisse

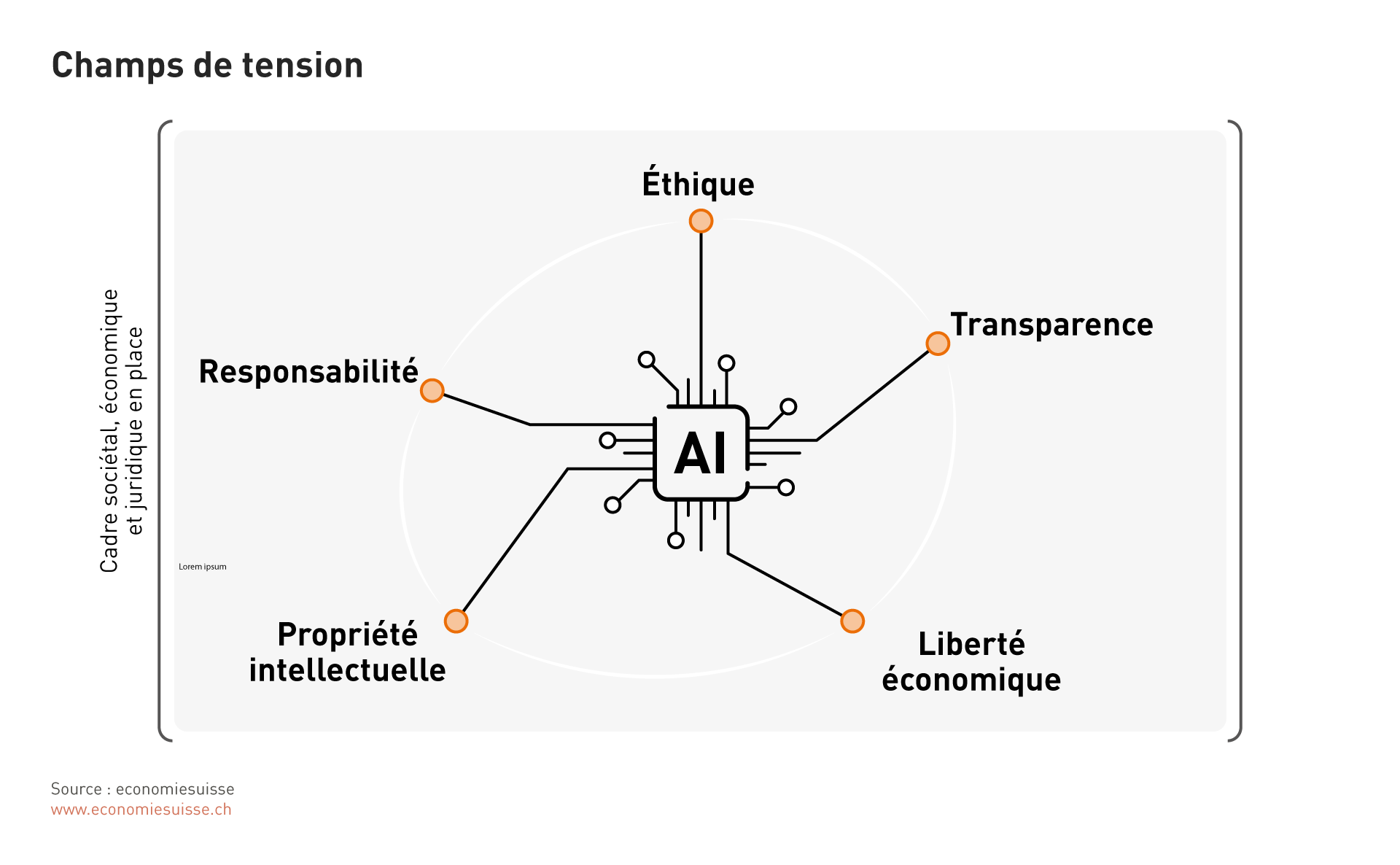

Champs de tension réglementaires

L’évolution de l’intelligence artificielle soulève diverses questions qui ne sont pas seulement d’ordre technique, mais qui touchent également des dimensions éthiques, économiques et juridiques. Dans le présent dossierpolitique, nous souhaitons aborder ces questions importantes en lien avec l’IA et montrer dans quelle mesure elles sont déjà couvertes par le cadre sociétal, économique et juridique en place en Suisse. Une adaptation même ponctuelle du cadre juridique ne doit être réalisée que dans les cas où les réglementations existantes ne peuvent pas être appliquées de manière appropriée à des faits impliquant l’IA avec une interprétation adéquate.

Éthique

Les questions autour de l’éthique sont importantes tant pour le développement que pour l’utilisation de l’IA. Du point de vue strictement juridique, les principes purement éthiques ne jouent un rôle que dans la mesure où ils sont formulés expressément et de manière concrète dans des règles légales. L’abondante jurisprudence relative au principe général de la bonne foi (art. 2 CC) ainsi que les principes de bonne gouvernance d’entreprise («good governance») contiennent toutefois de nombreuses règles intégrées sur la base d’une volonté d’équité ou d’éthique. Dans le cas de l’IA, il faut notamment tenir compte du fait que les processus pilotés par elle doivent répondre aux exigences éthiques de notre société, c’est-à-dire à nos valeurs et normes fondamentales.

L’intégration de principes éthiques dans le processus de développement de systèmes d’IA contribue à ce que les applications soient dignes de la confiance des utilisateurs et donc de la population. À cet égard, les entreprises devraient être conscientes de la responsabilité qui accompagne la création de technologies d’IA et s’engager à respecter des lignes directrices en matière d’éthique.

Les aspects suivants sont particulièrement pertinents à cet égard:

Inégalité de traitement: Les systèmes d’IA peuvent renforcer et promouvoir des préjugés s’ils ne sont pas entraînés sur la base de jeux de données représentatifs. Cela peut entraîner une inégalité de traitement non justifiée, ce dont il faut tenir compte lors du développement et de l’utilisation de systèmes d’IA. Il faut s’assurer qu’ils sont utilisés de manière juste et qu’une différenciation, entre différents groupes de clients par exemple, n’est faite que dans la mesure où des arguments matériellement convaincants le suggèrent.

Il existe déjà des instruments juridiques qui permettent de lutter contre des inégalités de traitement sans raison matérielle. En Suisse, par exemple, la Constitution interdit la discrimination, surtout à l’intention de l’État, mais celle-ci lie également les particuliers qui assument des tâches étatiques.

Aujourd’hui, la doctrine reconnaît largement qu’une inégalité de traitement sans raison matérielle lors de la conclusion d’un contrat peut constituer une atteinte à la personnalité. Il ne s’agit pas d’une protection absolue contre des inégalités de traitement, mais d’une «interdiction indirecte de discriminer, en vertu du droit privé, en ce sens qu’une inégalité de traitement fondée sur des caractéristiques d’une personne protégées par son droit de la personnalité peut constituer une atteinte à la personnalité.

Le droit de la personnalité et le droit pénal s’appliquent également à des situations impliquant des applications d’IA inéquitables, déloyales ou trompeuses: c’est le cas par exemple des «deep fakes», où la représentation insultante ou falsifiée d’une personne peut ainsi constituer une atteinte à sa personnalité. En présence d’une volonté de tromper, les éléments constitutifs d’une infraction pénale, formulés eux aussi de manière technologiquement neutre, sont réunis.

D’autres textes imposent clairement l’égalité de traitement aux particuliers. C’est le cas de la loi fédérale sur l’égalité entre femmes et hommes et de celle sur l’élimination des inégalités frappant les personnes handicapées.

Une IA bien entraînée peut même empêcher une inégalité de traitement. Des systèmes d’IA peuvent ainsi être plus neutres que des humains ou, à partir de décisions, identifier des schémas indiquant une inégalité de traitement.

Vie privée et protection des données: Lors de l’utilisation de systèmes d’IA, il convient de s’assurer que les règles applicables en matière de protection des données sont respectées à la fois en ce qui concerne les données fournies et les résultats générés. En Suisse, c’est avant tout la nouvelle loi sur la protection des données (LPD) qui est pertinente à cet égard. Celle-ci s’applique au traitement de données personnelles par des particuliers et des organes fédéraux. Début novembre 2023, le préposé fédéral à la protection des données et à la transparence (PFPDT) a confirmé que la loi sur la protection des données actuellement en vigueur est directement applicable à l’AI. Les dispositions ci-après sont particulièrement pertinentes à cet égard:

- minimisation des données (art. 6, al. 2 LPD),

- devoir d’informer / transparence (art. 19 LPD),

- profilage (art. 5, let. f-g LPD),

- décisions individuelles automatisées (art. 21, al. 1-3 LPD),

- droit d’accès (art. 25 LPD).

Une analyse des différents domaines concernés par l’utilisation de l’IA montre que le cadre juridique en vigueur offre presque toujours une prise adéquate. C’est le cas aujourd’hui et il appartiendra au législateur d’agir en temps utile pour régler des cas – dans l’éventualité où l’évolution de la technologie créerait des lacunes dans la loi.

L’IA et l’État

Comme nous l’avons expliqué, l’interdiction de discriminer dans les relations entre l’État et les citoyens va très loin et constitue une condition importante pour le respect des droits constitutionnels des citoyennes et citoyens dans une démocratie libérale comme la Suisse.

Dans ses lignes directrices sur l’intelligence artificielle pour l’administration fédérale, la Confédération aborde la question du risque de discrimination découlant de jeux de données lorsque des décisions sont fondées sur l’IA. Elle place l’être humain, sa dignité et son bien-être au centre. L’utilisation de l’IA doit «soutenir l’égalité des chances des personnes, mais aussi encourager et faciliter l’accès à la formation, aux biens, aux services et aux technologies». Les droits fondamentaux doivent être respectés à tout moment. Lorsqu’il existe une probabilité que des droits fondamentaux soient violés, en particulier dans le contexte de systèmes de «self learning», une analyse d’impact complète devrait être effectuée. Ce processus devrait s’accompagner d’une surveillance continue afin de mettre en place des mesures de protection et des contrôles appropriés. L’objectif premier est de protéger les personnes concernées de toute discrimination et stigmatisation. En même temps, le respect de la vie privée devrait être assuré par une application stricte des dispositions relatives à la protection des données. Ces développements se déroulent de manière analogue à ceux au sein du Conseil de l’Europe. L’objectif est également de s’assurer que les pouvoirs publics n’utilisent pas les outils d’IA d’une manière qui ne serait pas appropriée dans une société libérale comme la Suisse.

Transparence

En règle générale, les décisions sont acceptées lorsqu’elles sont prises de manière transparente et donc compréhensible. Il en va de même pour les décisions prises en utilisant l’IA. Les utilisateurs doivent pouvoir savoir quand une décision a été prise par une IA. Ils devraient également comprendre comment les systèmes d’IA aboutissent à leurs conclusions. Non seulement cela favorise la confiance, mais cela permet également d’identifier et de corriger d’éventuelles erreurs ou préjugés dans les systèmes. Dans ces conditions, il est essentiel de développer des méthodes pour expliquer les décisions d’IA. Pour cela, il faut des processus transparents. La nouvelle loi suisse sur la protection des données peut donc être utilisée comme base juridique: elle prévoit des dispositions en matière de transparence étendues eu égard aux décisions automatisées. En même temps, il faut éviter des exigences excessives. Des décisions prises par des humains peuvent, en effet, également manquer de transparence et reposer sur de nombreux préjugés (pas toujours conscients).

Pour l’OCDE aussi, la transparence est importante pour garantir la traçabilité. Elle exige des acteurs d’IA qu’ils fassent preuve de transparence afin de «favoriser une compréhension générale des systèmes d’IA» ainsi qu’une prise de conscience et une compréhension des interactions avec des systèmes d’IA.

Liberté économique

La liberté économique et la liberté de contracter sont deux des piliers d’une économie dynamique caractérisée par la libre concurrence. En Suisse, la liberté économique est un droit fondamental selon l’art. 26 Cst. La liberté contractuelle, inscrite dans le code des obligations, veut que, dans les limites de la loi, chacun est libre de décider avec qui il souhaite conclure une relation contractuelle. À noter, c’est important, que les systèmes d’IA ne limitent pas ces libertés, mais peuvent même les soutenir. L’IA peut servir d’outil pour prendre des décisions fondées et développer des modèles d’affaires innovants. En ce qui concerne la réglementation de l’IA, il faut s’assurer que la liberté économique, et notamment la liberté contractuelle, reste garantie.

Un contrat doit en principe respecter les limites fixées par le code des obligations, et notamment les art. 19, al. 2 et art. 20, al. 1. En même temps, il n’est pas interdit d’individualiser – indépendamment de la question de savoir si l’on fait appel à une IA. Une individualisation dans le sens de la liberté contractuelle est en principe possible et doit le rester. Pouvoir personnaliser une offre est effectivement indispensable pour la libre concurrence.

Propriété intellectuelle

En lien avec l’IA, les questions relatives à la propriété intellectuelle sont nombreuses: les systèmes d’IA sont souvent développés et entraînés sur la base de vastes volumes de données, d’algorithmes et d’œuvres créés par l’homme.

Des questions relatives aux droits d’auteur se posent également en ce qui concerne les résultats générés par des systèmes d’IA. Lorsque des données sont traitées à l’aide de l’intelligence artificielle, des données protégées peuvent être copiées numériquement, ce qui peut porter atteinte aux droits des auteurs. Des fragments d’un résultat généré par ChatGPT peuvent ainsi être protégés par des droits d’auteur, de sorte qu’un utilisateur éventuel porterait atteinte à ces droits sans le savoir.

Des questions se posent encore quant à la paternité des résultats produits par une IA. Si une IA peut produire des biens immatériels à bas coût, le droit de la propriété intellectuelle devra éventuellement être ajusté. En particulier lorsque des systèmes d’IA génèrent des œuvres créatives de manière autonome, cela pose la question de la protection et de l’«inventeur» de telles œuvres. S’il devient difficile d’attribuer clairement des actes créatifs ou inventifs à des êtres humains ou à des systèmes d’IA, les critères traditionnels de la «création intellectuelle» et de l’«activité inventive» pourraient, par exemple, être mis à l’épreuve. En effet, peut-on attribuer une performance intellectuelle à un produit créé par une IA? Une jurisprudence devra donc se développer sur cette question pour définir les limites du droit de la propriété intellectuelle en lien avec l’IA.

Les possibilités offertes par l’IA soulèvent par ailleurs des questions en ce qui concerne le droit des brevets. On n’a pas encore répondu à la question de savoir si une IA peut aussi être un inventeur ou alors à qui ce rôle revient, ou à partir de quel degré d’autonomie l’homme qui utilise une IA n’est plus considéré comme un inventeur. Pour trouver une réponse, il s’agit tout d’abord de revenir à l’idée initiale de la législation concernée et de la transposer à la situation particulière impliquant une IA.

Il n’est, toutefois, pas urgent d’adapter le droit de la propriété intellectuelle pour tenir compte de l’essor de l’IA, car le droit en vigueur semble offrir suffisamment de flexibilité. Entre les tribunaux qui continueront de développer les concepts juridiques pertinents et les discussions menées dans les milieux spécialisés, une approche appropriée et adaptée émergera. À l’échelle internationale, il existe déjà ici et là des ébauches de solution, sur la base desquelles les tribunaux clarifient les questions en suspens. Cela sera possible également en Suisse.

Responsabilité

L’exploitation de systèmes d’IA comporte des risques en matière de responsabilité. La première question qui se pose est celle de l’«autonomie» et, puis, celle de savoir à partir de quand une IA a réellement causé un dommage.

On peut imaginer un robot tondeuse qui au lieu de tondre la pelouse de son propriétaire tond le parterre de fleurs du voisin. Une fois que le mal est fait, on a, primo, le voisin qui demande à être remboursé pour ses fleurs, secundo, le propriétaire du robot qui est sommé par le voisin de payer et, tertio, le fabricant du robot contre lequel le propriétaire va se retourner.

Il convient ici de faire la distinction entre une décision erronée et un défaut du produit. On parle de la première «si, lors du choix entre plusieurs alternatives, on choisit le comportement qui conduit à un dommage ou à une aggravation du dommage», alors qu’un défaut du produit «découle d’un défaut de ses composants».

En Suisse, la loi sur la responsabilité du fait des produits (LRFP), entre autres, régit la responsabilité du producteur pour les produits défectueux. Cette loi présente des similitudes avec la directive européenne 85/374/CEE, qu’il est question de réviser, notamment en raison de la rapidité des évolutions technologiques. Dans ce cadre, on aborde plusieurs faiblesses du régime de la responsabilité du fait des produits, comme le champ d’application restreint aux produits malgré l’importance croissante des logiciels, la détermination de la défectuosité des produits susceptibles d’être développés ou la possibilité de faire valoir des droits en raison de la répartition du fardeau de la preuve. Le législateur suisse serait bien inspiré d’examiner, lui aussi, sérieusement ces questions.

À l’heure actuelle, un système d’IA ne peut pas être un sujet responsable, car il ne possède pas la capacité juridique. On ignore pour l’heure si un système d’IA entre dans la définition des logiciels figurant dans la loi sur la responsabilité du fait des produits. Dans le domaine de la responsabilité, certaines questions demeurent ouvertes et il sera intéressant de voir comment la jurisprudence y répondra. La distinction entre défaut du produit et décision inopportune, mentionnée ci-dessus, jouera probablement un rôle important à cet égard.